23일(현지시간) 뉴욕타임스(NYT) 등 외신은 페이스북의 내부 문건을 인용, 회사가 2019년 주요 시장인 인도에서의 알고리즘 실험을 위해 3주간 가계정을 사용한 결과 상당한 양의 폭력 콘텐츠가 추천되는 것을 확인했다고 보도했다.

|

21세 인도 여성 가계정에 ‘참수 당한 시체’ 사진 공유돼

블룸버그에 따르면 당시 페이스북은 인도 서부 도시 자이푸르에 거주하는 21세 여성이라는 허구 인물을 설정해 가계정을 만들었다. 페이스북은 이용자만 3억4000만명에 달하는 자사 최대 시장인 인도에서 알고리즘을 점검하기 위해 실험을 진행했다고 설명했다. 해당 가계정은 페이스북 알고리즘이 추천한 친구나 페이지 또는 그룹만 팔로우했다.

실험에 참가했던 한 페이스북 직원은 보고서에 “이 테스트 사용자의 뉴스피드를 관찰하는 지난 3주 동안 죽은 사람의 사진을 평생 본 것보다 더 많이 봤다”라고 기술했다. 보고서는 테스트 사용자 계정이 “노골적인 증오심을 담은 콘텐츠와 잘못된 정보로 가득 찼다”라고 결론지었다.

NYT는 해당 실험이 페이스북이 이용자들에 큰 악역향을 미칠 것이라는 인권 운동가와 정치인의 비판을 뒷받침해주는 근거라고 꼬집었다. 앞서 페이스북에서 일했던 프랜시스 하우겐은 페이스북 자회사 인스타그램이 10대 소녀들의 정신 건강에 해롭다는 것을 인지하고도 이를 방치하는 등 알고리즘에 문제가 있다고 내부고발한 바 있다.

|

가짜 뉴스 분류 예산 87%, 이용자 10% 불과한 미국에 사용

NYT는 “유해 정보를 분류하는 데 소요되는 회사의 글로벌 예산 중 87%는 사용자가 10% 수준인 미국에 할당됐고, 세계 다른 모든 지역은 나머지 예산 13%로 충당해야 했다”라고 지적했다.

이에 대해 페이스북 측은 “미국을 제외한 다른 나라에서는 가짜 뉴스를 가려내는 별도의 파트너가 존재한다”라며 “해당 수치는 잘못됐다”라고 해명했다. 앤디 스톤 페이스북 대변인은 “페이스북은 가장 널리 사용되는 두 언어인 힌디어와 벵골어를 포함해 다양한 언어에서 증오심 표현을 찾기 위한 기술에 상당히 투자했다”라며 “올해 페이스북에서 혐오 콘텐츠 양을 절반으로 줄었다”라고 강조했다.

한편, 페이스북은 마약 카르텔과 인신매매 집단이 페이스북을 악용하고 있다는 점을 알고도 대처하지 않았다고 내부 고발자 하우겐은 주장했다. 마크 저커버그 페이스북 최고경영자(CEO)는 사실무근이라고 선을 그은 상태다. 최근 페이스북이 사명 변경을 추진하는 것도 이같은 폭로로 추락한 이미지를 바꾸려는 것 아니냐는 지적도 나오고 있다.

![[포토]이가영,부드러운 티샷 공략](https://spnimage.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110100330t.jpg)

![[포토] '트릭 오어 트릿' 진행하는 바이든 대통령 부부](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24103102211t.jpg)

![[포토] 송민혁 '이글 2개, 버디7개 잡은 날'](https://spnimage.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24103100152t.jpg)

![[포토]치솟던 배춧값 대폭 하락…"물량 충분해"](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24103101370t.jpg)

![[포토]삼성전자 반도체 영업익 4조](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24103101369t.jpg)

![[포토]하모니카 연주가 이윤석의 연주](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24103101230t.jpg)

![[포토]민통선 주민들 트랙터 시위](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24103101122t.jpg)

![[포토] 서울시예산안 설명하는 오세훈 시장](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24103100890t.jpg)

![[포토] 벤틀리모터스코리아, '더 뉴 컨티넨탈 GT 스피드' 공개](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24103100418t.jpg)

![[포토] 2024 서울 문화원 엑스포](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/10/PS24103001770t.jpg)

![[포토]이가영,정상을 바라본다](https://spnimage.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110100331t.jpg)

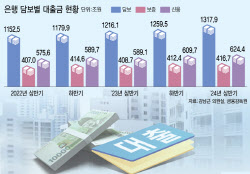

![[단독]대출 74%가 담보·보증대출…위험 피하는 은행](https://image.edaily.co.kr/images/Photo/files/NP/S/2024/11/PS24110100154b.jpg)